AIは予想より“ポンコツ”だった? 共通テストの数学、ChatGPTでも平均点未満という結果に驚く:NEWS Weekly Top10

ITmedia NEWS Weekly AccessTop10

2024年1月13日〜1月19日大学入試共通テストが行われた先週、「生成AIに試験問題を解かせてみた」というブログ(note)を紹介した記事がアクセス7位に入った。

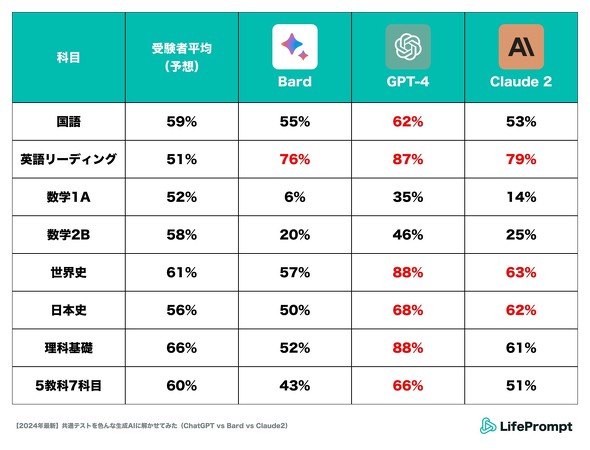

点数を競ったのは、米OpenAIの「ChatGPT」(GPT-4)、米Googleの「Bard」、米Anthropicの「Claude2」の3つの文章生成AI。企業へのAI導入コンサルティングなどを手掛けるLifePrompt(東京都千代田区)による実験だ。

結果を一読して意外だったのは、数学の正答率の圧倒的な低さだ。どのAIも受験生の平均点予想を上回れず、正答率は最大で46%(ChatGPTの「数学2B」)。Bardの「数学1A」に至ってはわずか6%しか取れていない。英語や国語、歴史科目などに比べても、目に見えて低い数字だ。

AIやコンピュータ、ロボットが「できること」のイメージは、ChatGPT以降、大きく変わったように思う。それまでは、AIやコンピュータは、特に数字や計算に関しては「間違わない」イメージがあった。今回の実験ブログを読む前、筆者も「受験5教科の中なら、AIは数学が一番得意では」と予想したのだが、真逆の結果だったのだ。

なぜ数学の正答率が低かったのか。LifePromptは、(1)生成AIの計算スキルが高校数学の範囲を簡単に解けるレベルまで進化していなかったこと、(2)共通テスト数学の特殊な解答形式に対応できなかったこと――をその理由に挙げている。

(2)のキモは、問題文と回答欄の読み解きだ。共通テストの問題は、問題文や式の中に四角い空欄が設けられ、「ア」「イ」などと片仮名がふられて、そこにあてはまる数字や記号を答える形式。Google BardやClaude2は特に、片仮名の当てはめでミスをしたという。

つまり、人間に解かせるために作られた問題形式の読み解きが、AIにはまだ難しい(正確に解かせるためには、より適切なプロンプトを与えてやる必要がある)ということのようだ。

かつて、SF的なAIやロボットのイメージは、完璧に計算できてロジカルで冷たくて、人間が太刀打ちできない何かだった。だが、こうして生成AIが日常に浸透してくると、イメージと違うところも多く、意外と“ポンコツ”な部分もあるんだなあとホッコリすることがある。

なんて言っていられるのも今年のうちぐらいで、2025年ごろにはもっと完璧なAIが現れて、「これが……シンギュラリティ……」とか言っているのかもしれないが。

関連記事

大学入試共通テスト、3つのチャットAIに解かせてみたら? GPT-4はバケモノだった

大学入試共通テスト、3つのチャットAIに解かせてみたら? GPT-4はバケモノだった

LifePromptは16日、大学入試共通テストを3つのチャットAIに解かせた結果を「note」で公開した。「やはりGPT-4はバケモノだった」という。 AIと恋愛できるiOSアプリ「恋するAI」 マッチングアプリ「タップル」提供元が開発 「少子化問題を解決したい」

AIと恋愛できるiOSアプリ「恋するAI」 マッチングアプリ「タップル」提供元が開発 「少子化問題を解決したい」

AIと恋愛できるiOSアプリ「恋するAI」登場 マッチングアプリ「タップル」提供元が開発 「少子化問題を解決したい」 芥川賞作「ChatGPTなど駆使」「5%は生成AIの文章そのまま」 九段理江さん「東京都同情塔」

芥川賞作「ChatGPTなど駆使」「5%は生成AIの文章そのまま」 九段理江さん「東京都同情塔」

芥川賞作品「東京都同情塔」は、ChatGPTなど生成AIを駆使して書いた――著者である九段理江さんが受賞会見でこう打ち明けた。 「ChatGPTを駆使した」芥川賞作品を読む “ポリコレ的にOKな表現”が支配する未来とは

「ChatGPTを駆使した」芥川賞作品を読む “ポリコレ的にOKな表現”が支配する未来とは

芥川賞を受賞した『東京都同情塔』は、「一部がChatGPTなどの生成AIで書かれた」という話題が一人歩きしているが、実際に読んでみて、「なんだこれは」と衝撃を覚えた。 被災地支援に“ロボット犬” 陸上自衛隊が運用中 避難所への誘導支援などに活用

被災地支援に“ロボット犬” 陸上自衛隊が運用中 避難所への誘導支援などに活用

陸上自衛隊は日、令和6年能登半島地震の被災地に“ロボット犬”を導入していると発表した。被災者を2次避難所まで移送する誘導支援に活用したという。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR